Si buscas

hosting web,

dominios web,

correos empresariales o

crear páginas web gratis,

ingresa a

PaginaMX

Por otro lado, si buscas crear códigos qr online ingresa al Creador de Códigos QR más potente que existe

INTELIGENCIA ARTIFICIAL

FUNDAMENTOS DE LAS REDES NEURONALES

ANTECENDENTES

Sin embargo a pesar de disponer de herramientas y de lenguajes de programación diseñados para el desarrollo de máquinas inteligentes, existe un problema de fondo que limita los resultados: estas máquinas se implementan sobre ordenadores basados en la filosofía de Von Neumann, y se apoyan en una descripción secuencial del proceso de tratamiento de la información.

Las primeras explicaciones teóricas sobre el cerebro y el pensamiento fueron dadas por algunos filósofos griegos, como Platón y Aristóteles, quienes fueron apoyados después por Descartes y filósofos empiristas.

Alan Turing, en 1936, fue el primero en estudiar el cerebro como una forma de ver el mundo de la computación, pero quienes primero concibieron algunos fundamentos de la computación neuronal fueron Warren McCulloch y Walter Pitts, después otras teorías iniciales fueron expuestas por Donald Hebb. Pero solo hasta 1957 Frank Rosenblatt comenzó el desarrollo del Perceptrón, la red neuronal más antigua.

MODELO DE NEURONA ARTIFICIAL

La formulación de la neurona artificial como dispositivo no lineal constituye una de sus características más destacables, y una de las que proporciona un mayor interés a los RNA, pues el tratamiento de problemas altamente no lineales no suele ser fácil de abordar mediante técnicas convencionales.

ARQUITECTURA DE REDES NEURONALES

Se denomina arquitectura a la topología, estructura o patrón del conexionado de una red neuronal. En un RNA los nodos se conectan por medio de sinapsis, esta estructura de conexiones sinápticas determina el comportamiento de la red. Las conexiones sinápticas son direccionales, es decir, la información solamente se propaga en un único sentido (desde la neurona presináptica a la postsináptica.

En general, las neuronas se agrupan en unidades estructurales que denominamos capas. Las neuronas de una capa se agrupan, a su vez, para formar grupos neuronales (clusters).

Dentro de un grupo, ó de una capa, si no existe éste tipo de agrupación, las neuronas suelen ser del mismo tipo. Finalmente, el conjunto de una o más capas constituye la red neuronal.

Se distinguen tres tipos de capas: "a" de entrada, "b" de salida y "c" ocultas. Una capa de entrada o sensorial está compuesta por neuronas que reciben datos o señales procedentes del entorno (por ejemplo, proporcionados por sensores).

Una capa de salida es aquella cuyas neuronas proporcionan la respuesta de la red neuronal (sus neuronas se conectan a efectores).

Una capa oculta es aquella que no tiene una conexión directa con el entorno, es decir, que no se conecta directamente ni a órganos sensores ni a efectores.

Este tipo de capa proporciona a la red neuronal grados de libertad adicionales, gracias a los cuales se encuentran representaciones internas correspondientes a rasgos del entorno, proporciona una mayor riqueza computacional.

Las conexiones entre las neuronas son excitatorias o inhibitorias: Un peso sináptico negativo define una conexión inhibitoria, mientras que uno positivo determina una conexión excitatoria.

Habitualmente, no se suele definir una conexión como de un tipo o de otro, sino que por medio del aprendizaje se obtiene un valor para el peso, que incluye signo y magnitud.

Por otra parte, se distingue entre conexiones intra-capa e inter-capa.

Las conexiones intra-capa, también denominadas laterales, tienen lugar entre las neuronas pertenecientes a una misma capa, mientras que las conexiones inter-capa se producen entre las neuronas de diferentes capas.

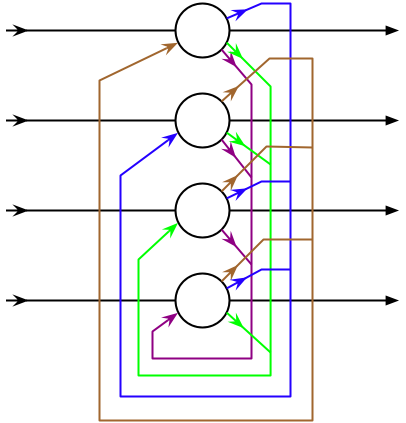

Existen además conexiones realimentadas, que tienen un sentido contrario al de entrada-salida.

En algunos casos existe realimentación incluso de una neurona consigo misma.

CLASIFICACION DE LOS MODELOS NEURONALES

EL PERCETRON:

dentro del campo de las redes neuronales tiene dos acepciones.Puede referirse a un tipo de red neuronal artificial desarrollado por Frank Rosenblatt.Y dentro de la misma teoría de Frank Rosenblatt. También puede entenderse como la neurona artificial y unidad básica de inferencia en forma dediscriminador lineal. Es decir un algoritmo capaz de generar un criterio para seleccionar un grupo, de un grupo de componentes más grande. La limitación de este algoritmo es que si dibujamos en un plot estos elementos. Se deben poder separar con un hiperplano los elementos "deseados" de los "no deseados". El perceptrón puede utilizarse con otros perceptrones u otro tipo de neurona artificial, para formar redes neuronales más complicadas.

ADALINE:

Posee la ventaja de que su gráfica de error es un hiperparaboloide que posee o bien un único mínimo global, o bien una recta de infinitos mínimos, todos ellos globales. Esto evita la gran cantidad de problemas que da el perceptrón a la hora del entrenamiento debido a que su función de error (también llamada de coste) posee numerosos mínimos locales.

PERCETRON MULTICAPA:

MEMORIAS ASOCIATIVAS:

Es el almacenamiento y recuperación de información por asociación con otras informaciones.

Un dispositivo de almacenamiento de información se llama memoria asociativa si permite recuperar información a partir de conocimiento parcial de su contenido, sin saber su localización de almacenamiento. A veces también se le llama memoria de direccionamiento por contenido.

Una memoria asociativa puede almacenar información y recuperarla cuando sea necesario, es decir, una red retroalimentada, cuya salida se utiliza repetidamente como una nueva entrada hasta que el proceso converge. Puede recuperar dicha información basándose en el conocimiento de parte de ésta (clave).

MÁQUINA DE BOLTZMANN

Es un tipo de red neuronal recurrente estocástica. El nombre le fue dado por los investigadores Geoffrey Hinton y Terry Sejnowski. Las máquinas de Boltzmann pueden considerarse como la contrapartida estocástica y generativa de las redes de Hopfield. Fueron de los primeros tipos de redes neuronales capaces de aprender mediante representaciones internas, son capaces de representar y (con tiempo suficiente) resolver complicados problemas combinatorios. Sin embargo, debido a una serie de cuestiones que se abordan más adelante, las máquinas de Boltzmann sin restricciones de conectividad no han demostrado ser útiles para resolver los problemas que se dan en la práctica en el aprendizaje o inferencia de las máquinas.PROPAGACIÓN HACIA ATRÁS

REDES DE HOPFIELD

es una forma de red neuronal artificial recurrente inventada por John Hopfield. Las redes de Hopfield se usan como sistemas de Memoria asociativa con unidades binarias. Están diseñadas para converger a un mínimo local, pero la convergencia a uno de los patrones almacenados no está garantizada.Las unidades de las redes Hopfield son binarias, es decir, sólo tienen dos valores posibles para sus estados y el valor se determina si las unidades superan o no un determinado umbral.

REDES SUPERVISADAS

REDES UNIDIRECCIONALES

APRENDIZAJE HEBBIANO

Este método de aprendizaje aplicado a las redes neuronales artificiales, las conexiones entre las neuronas de entrada activas y las neuronas de salida activas se refuerzan durante el entrenamiento: coincidencias entre actividad de entrada y actividad de salida se intensifican. Mientras que las conexiones entre neuronas de entrada inactivas y neuronas de salida (Activas o Inactivas) no se refuerzan.

Este método de aprendizaje puede ser tanto supervisado como no supervisado. Cuando es supervisado, la respuesta correcta para el dato de entrada es introducida para cada neurona de salida, y los pesos sinápticos entre las neuronas activas se incrementan, mientras que los pesos entre neuronas que no estén activas simultáneamente permanecen igual que estaban.

El problema de este método es que no tiene en cuenta la eficacia de la red. Así, aunque la red ya este entrenada y los valores de entrada generen valores de salida correctos, la regla de aprendizaje continua incrementando los pesos sinápticos entre neuronas activas.

Esta regla puede interpretarse matemáticamente teniendo en cuenta que si dos neuronas en cualquier lado de la sinápsis son activadas simultáneamente, la longitud de la sinápsis se incrementará.

PERCETRON

Dentro del campo de las redes neuronales tiene dos acepciones.Puede referirse a un tipo de red neuronal artificial desarrollado por Frank Rosenblatt.Y dentro de la misma teoría de Frank Rosenblatt. También puede entenderse como la neurona artificial y unidad básica de inferencia en forma dediscriminador lineal. Es decir un algoritmo capaz de generar un criterio para seleccionar un grupo, de un grupo de componentes más grande. La limitación de este algoritmo es que si dibujamos en un plot estos elementos. Se deben poder separar con un hiperplano los elementos "deseados" de los "no deseados". El perceptrón puede utilizarse con otros perceptrones u otro tipo de neurona artificial, para formar redes neuronales más complicadas.

ADALINA

(ADAptative LINear Element) es un tipo de red neuronal artificial desarrollada por el profesor Bernie Widrow y su alumno Ted Hoff en la Universidad de Stanford en 1960.A diferencia del perceptrón, a la hora de modificar los pesos durante el entrenamiento, el Adaline tiene en cuenta el grado de corrección de la salida estimada respecto a la deseada.

posee la ventaja de que su gráfica de error es un hiperparaboloide que posee o bien un único mínimo global, o bien una recta de infinitos mínimos, todos ellos globales. Esto evita la gran cantidad de problemas que da el perceptrón a la hora del entrenamiento debido a que su función de error (también llamada de coste) posee numerosos mínimos locales.

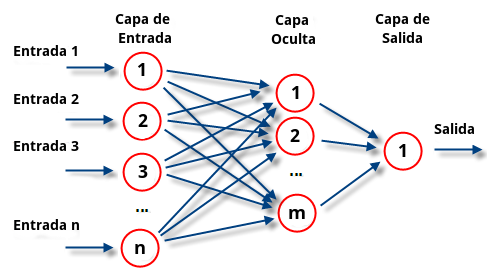

PERCETRON MULTICAPA

Es una red neuronal artificial (RNA) formada por múltiples capas, esto le permite resolver problemas que no son linealmente separables, lo cual es la principal limitación del perceptrón(también llamado perceptrón simple). El perceptrón multicapa puede ser totalmente o localmente conectado.Las capas pueden clasificarse en tres tipos:

- Capa de entrada: Constituida por aquellas neuronas que introducen los patrones de entrada en la red. En estas neuronas no se produce procesamiento.

- Capas ocultas: Formada por aquellas neuronas cuyas entradas provienen de capas anteriores y cuyas salidas pasan a neuronas de capas posteriores.

- Capa de salida: Neuronas cuyos valores de salida se corresponden con las salidas de toda la red.

La propagación hacia atrás (también conocido como retropropagación del error o regla delta generalizada), es un algoritmo utilizado en el entrenamiento de estas redes, por ello, el perceptrón multicapa también es conocido como red de retropropagación.

- El Perceptrón Multicapa no extrapola bien, es decir, si la red se entrena mal o de manera insuficiente, las salidas pueden ser imprecisas.

- La existencia de mínimos locales en la función de error dificulta considerablemente el entrenamiento, pues una vez alcanzado un mínimo el entrenamiento se detiene aunque no se haya alcanzado la tasa de convergencia fijada.

REDES AUTOORGANIZADAS

MODELOS NO SUPERVISADOS

Es un método de Aprendizaje Automático donde un modelo es ajustado a las observaciones. Se distingue del Aprendizaje supervisado por el hecho de que no hay un conocimiento a priori. En el aprendizaje no supervisado, un conjunto de datos de objetos de entrada es tratado. Así, el aprendizaje no supervisado típicamente trata los objetos de entrada como un conjunto de variables aleatorias, siendo construido un modelo de densidad para el conjunto de datos.

El aprendizaje no supervisado puede ser usado en conjunto con la Inferencia bayesiana para producir probabilidades condicionales (es decir, aprendizaje supervisado) para cualquiera de las variables aleatorias dadas. El Santo Grial del aprendizaje no supervisado es la creación de un código factorial de los datos, esto es, un código con componentes estadísticamente independientes. El aprendizaje supervisado normalmente funciona mucho mejor cuando los datos iniciales son primero traducidos en un código factorial.

El aprendizaje no supervisado también es útil para la compresión de datos: fundamentalmente, todos los algoritmos de compresión dependen tanto explícita como implícitamente de una distribución de probabilidad sobre un conjunto de entrada.

Otra forma de aprendizaje no supervisado es la agrupación (en inglés, clustering), el cual a veces no es probabilístico.

- No necesitan de un profesor externo

- Muestran cierto grado de Auto-organización

- La red descubre en los datos de entrada y de forma autónoma: características, regularidades, correlaciones y categorías

- Suelen requerir menores tiempos de entrenamiento que las supervisadas

- Arquitectura simple. Habitualmente son: (una sola capa o Feed-forward)

- Tipos fundamentales: Kohonen y Grossberg

- Abordan los siguientes tipos de problemas: familiaridad, análisis de componentes principales, agrupamiento, prototipado y extracción y relación de características

MODELO DE KOHONEN

T. Kohonen presentó en 1982 un sistema con un comportamiento semejante al del cerebro. Se trataba de un modelo de red neuronal con capacidad para formar mapas de características de manera similar a como ocurre en el cerebro. En éste hay neuronas que se organizan en muchas zonas, de forma que las informaciones captadas del entorno a través de los órganos sensoriales se representan internamente en forma de mapas bidimensionales.

Este modelo tiene dos variantes, denominadas LVQ (Learning Vector Quantization) y TPM (Topology-Preserving Map). Ambas forman mapas topológicos para establecer características comunes entre las informaciones de entrada.

ARQUITECTURA

La versión original (LVQ) consta de dos capas con N neuronas de entrada y M de salida. Cada una de las N neuronas de entrada se conecta a las M de salida a través de conexiones hacia adelante (feedforward).

Entre las neuronas de la capa de salida existen conexiones laterales de inhibición (peso negativo) implícitas. Cada una de estas neuronas va a tener cierta influencia sobre sus vecinas. El valor que se asigne a los pesos de las conexiones feedforward entre las capas de entrada y salida durante el proceso de aprendizaje de la red va a depender precisamente de esta interacción lateral.

La influencia que una neurona ejerce sobre las demás es función de la distancia entre ellas, siendo muy pequeña cuando están muy alejadas.

FUNCIONAMIENTO

El funcionamiento es relativamente simple. Cuando se presenta a la entrada una información Ek, cada una de las M neuronas de la capa de salida la recibe a través de la conexiones feedforward con pesos wji.También estas neuronas reciben las correspondientes entradas debidas a las conexiones laterales con el resto de las neuronas de salida y cuya influencia dependerá de la distancia a la que se encuentren.

APRENDIZAJE

Es de tipo OFF LINE, por lo que se distingue una etapa de aprendizaje y otra de funcionamiento. También utiliza un aprendizaje no supervisado de tipo competitivo. Sólo una neurona de la capa de salida se activa ante la entrada, ajustándose los pesos de las conexiones en función de la neurona que ha resultado vencedora.

Durante la etapa de entrenamiento, se presenta a la red un conjunto de informaciones de entrada para que ésta establezca, en función de la semejanza entre los datos, las diferentes categorías (una por neurona de salida) que servirán durante la fase de funcionamiento para realizar clasificaciones de nuevos datos que se presenten a la red. Los valores finales de los pesos de las conexiones entre cada neurona de la capa de salida con las de entrada se corresponderán con los valores de los componentes del vector de aprendizaje que consigue activar la neurona correspondiente.

El aprendizaje no concluye después de presentarle una vez todos los patrones de entrada, sino que habrá que repetir el proceso varias veces para refinar el mapa topológico de salida, de tal forma que cuantas más veces se presenten los datos, tanto más se reducirán las zonas de neuronas que se deben activar ante entradas parecidas, consiguiendo que la red pueda realizar una clasificación más selectiva.

4. APLICACIONES

Las características de las RNA las hacen bastante apropiadas para aplicaciones en las que no se dispone a priori de un modelo identificable que pueda ser programado, pero se dispone de un conjunto básico de ejemplos de entrada (previamente clasificados o no). Asimismo, son altamente robustas tanto al ruido como a la disfunción de elementos concretos y son fácilmente paralelizables.

Esto incluye problemas de clasificación y reconocimiento de patrones de voz, imágenes, señales, etc. Asimismo se han utilizado para encontrar patrones de fraude económico, hacer predicciones en el mercado financiero, hacer predicciones de tiempo atmosférico, etc.

También se pueden utilizar cuando no existen modelos matemáticos precisos o algoritmos con complejidad razonable, por ejemplo la red de Kohonen ha sido aplicada con un éxito más que razonable al clásico problema del viajante (un problema para el que no se conoce solución algorítmica de complejidad polinómica).

Otro tipo especial de redes neuronales artificiales se ha aplicado en conjunción con los algoritmos genéticos (AG) para crear controladores para robots. La disciplina que trata la evolución de redes neuronales mediante algoritmos genéticos se denomina Robótica Evolutiva. En este tipo de aplicación el genoma del AG lo constituyen los parámetros de la red (topología, algoritmo de aprendizaje, funciones de activación, etc.) y la adecuación de la red viene dada por la adecuación del comportamiento exhibido por el robot controlado (normalmente una simulación de dicho comportamiento).

Se estima que a pesar de las limitaciones técnicas, las redes neuronales aplicadas a la Bibliometría constituyen un campo de investigación muy prometedor. Un ejemplo es presentado a continuación. La disciplina multidisciplinar de las redes neuronales es aplicada en esta sección, donde se

Asume a la producción de los documentos de patentes como indicador de la capacidad de desarrollo industrial. El objetivo es identificar posibles competidores, alianzas estratégicas, dependencia tecnológica, etc.

Las aplicaciones candidatas son aquellos problemas que en principio podrían ser resueltos con este tipo de tecnología que ofrecen las redes neuronales artificiales. Las aplicaciones en desarrollo son aquellas en las que se han realizado los estudios oportunos del problema y se dispone de un prototipo de red al que se le ha entrenado para resolver una versión simplificada del problema. Por último las aplicaciones demostradas son redes que de hecho ya están siendo utilizadas para resolver un problema real.

PRONOSTICOS

En ocasiones, los modelos convencionales hacen suposiciones sobre la forma de la distribución de la población, suposiciones que pudieran o no estar sujetas a verificación. Por ejemplo, los intervalos de estimación que usan un modelo de regresión, asumen que la población fundamental sigue una distribución normal.

El campo de desarrollo de la inteligencia artificial pretende duplicar el proceso del cerebro humano y el sistema nervioso mediante la computadora. Aunque este campo se origina en la biología y en la psicología, está avanzando con rapidez hacia otras áreas, incluyendo los negocios y la economía. Los tres principales impulsos en la inteligencia artificial.

![]()

![]()

![]()

![]()

![]()